如何自己写一个网络爬虫

这里是维基百科对网络爬虫的词条页面。网络爬虫以叫网络蜘蛛,网络机器人,这是一个程序,其会自动的通过网络抓取互联网上的网页,这种技术一般可能用来检查你的站点上所有的链接是否是都是有效的。当然,更为高级的技术是把网页中的相关数据保存下来,可以成为搜索引擎。

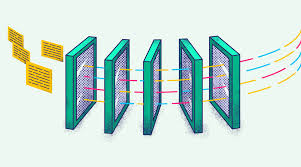

从技相来说,实现抓取网页可能并不是一件很困难的事情,困难的事情是对网页的分析和整理,那是一件需要有轻量智能,需要大量数学计算的程序才能做的事情。下面一个简单的流程:

在这里,我们只是说一下如何写一个网页抓取程序。

首先我们先看一下,如何使用命令行的方式来找开网页。

telnet somesite.com 80

GET /index.html HTTP/1.0

按回车两次

使用telnet就是告诉你其实这是一个socket的技术,并且使用HTTP的协议,如GET方法来获得网页,当然,接下来的事你就需要解析HTML文法,甚至还需要解析Javascript,因为现在的网页使用Ajax的越来越多了,而很多网页内容都是通过Ajax技术加载的,因为,只是简单地解析HTML文件在未来会远远不够。当然,在这里,只是展示一个非常简单的抓取, ...

陈皓(左耳朵耗子)

陈皓(1976年-2023年5月13日),男,MegaEase创始人、资深技术专家、程序员。2023年5月13日,陈皓心梗逝世,享年47岁。(来源:百度百科)

公告

由于酷壳(coolshell.cn)是托管在外网,在国内访问较慢,浏览体验不是很好,且怕后续域名或主机未续费的话,整个博客站点的资源就无法访问了,故爬取了酷壳网的整站的内容,使用 Hexo 重新生成了一个镜像站。

本站所有内容均为酷壳网内容镜像,未对正文内容调整,仅对部分内容正文排版及内容资源文件的URL引用做了调整,所有内容版权归原作者所有。

分类

标签

HTTPS cache J++ CSS3 BT 系统管理 Sort Glassfish bug IDE IE ASP W3C 伪装 STL DIP MapReduce Pylot Thin Provisioning WCat 评论 Bjarne Stroustrup Ruby XML mvcc Issue 9 dygraphs JWT QUIC API设计 vi MongoDB Coding timestamp Eclipse GC Gist Apache 代理 实习生 InI FAQ Kinect Sixth Sense Grinder email brainfuck 验证码 Sun thread Java Fast Recovery Redirections Jon Lech Johansen Bret Victor VB.NET etcd debugfs Hash Subversion Open Source Bitcoin ReCAPTCHA Microsoft Hibernate cas Unicode Oracle C++ Apache JMeter Unicode High Availability wtfjs.com Quora VideoCapture Bash Android CVS Polyglot Division of Labour Demo Spring Justin Frankel Linux Fantom 安全 AES 桌面应用 WinAmp

网站资讯

文章数目 :

740

本站总字数 :

1304.8k

本站访客数 :

本站总访问量 :

最后更新时间 :